Maschinen lernen hören mit KI? – Im Artikel über die Wirkung des Sprechens hatte ich von einem Interview mit dem Sprechwirkungsforscher Professor Dr. Walter F. Sendlmeier geschrieben. Er hat früher u. a. an der Entwicklung von automatischer Spracherkennung geforscht – lange vor Siri & Alexa. Und er meinte, es hätte damals ein gravierendes Problem gegeben: „Die Erkennungsrate der Systeme sank drastisch, wenn ihre Nutzer in einem erregten Zustand sprachen. – Stellen Sie sich vor, Sie wollen mit der Stimme eine Tür entriegeln oder das Schiebedach Ihres Autos schließen, weil es regnet. – Je erregter man spricht, desto stärker sinken die Erkennungsraten. Wenn man jedoch weiß, wie sich die Aussprache in Abhängigkeit von unterschiedlichen emotionalen Zuständen verschiebt, kann man Programme entwickeln, die diese Einflüsse des emotionalen Ausdrucks bei der Signalanalyse kompensieren.“

Bei diesen Forschungen ging es also schon darum, dass Maschinen hören lernen. Sie sollten jedoch nur die rein sachliche Information erkennen, selbst wenn Emotionen ins Spiel kamen. Die Maschine sollte hören, was gesagt wird – und ausblenden, wie es gesagt wird.

Hören mit KI – Maschinen trainieren

Bei audEERING hingegen, die schon im ersten Teil dieser Artikel-Serie vorkamen, geht es eher ums Gegenteil: Maschinen lernen vor allem hören, wie etwas gesagt wird. Es geht weniger um das Wort selbst, vielmehr um die Bewertung all jener Dinge, die in diesem Wort mitschwingen: Stimmführung, Lautstärke, Sprachrhythmus…

So was herauszuhören, fällt auch Menschen nicht immer leicht. Das ist oft ein Problem; denn wenn wir miteinander reden, geht es fast nie um rein sachliche Dinge. Oft ist das, was bei einem Wort mitschwingt, viel entscheidender. – Dennoch, wenn eine Emotion mitschwingt, dann werden viele diese Emotion gleich beurteilen. Sie stellen fest: Das klingt glücklich, verärgert usw.

Genau so lernt auch die KI von audEERING. Das Unternehmen beschäftigt ein großes Team von hörenden Menschen. Sie heißen Annotatoren (also „Beifüger“) und ordnen (bzw. annotieren) gesprochene Worte bzw. Daten nach wahrgenommenen Emotionen. Aus all den menschlichen Urteilen wird ein Mittel gebildet. Und anhand dessen wird die KI trainiert bzw. das Hören mit KI überhaupt erst möglich.

„Dieses Systematisieren, das Labeln der Daten, ist extrem wichtig“, hat mir Dagmar Schuller, die Geschäftsführerin von audEERING, erklärt. „Nur so kommt man überhaupt zu einer guten Methode. Es wird zwar auch heute schon darüber gesprochen, die Generierung und das Labeln der Daten komplett den Maschinen zu überlassen. Aber dieses sogenannte Automated Machine Learning steckt noch in den Kinderschuhen. Aktuell muss das noch komplett von Menschen übernommen werden, um dann Algorithmen entwickeln zu können, die aus den Daten das Bestmögliche herausholen.“

Hören mit KI – besser als Menschen?

In diesem Blog ging es schon häufiger darum, wie sehr wir verlernt haben zu hören. (Wir sind die „Großmeister im Nichthören“.) Zumindest in den Ländern der westlichen Welt haben Menschen ihre Ohren seit Beginn der Industrialisierung vernachlässigt. In einer zu lauten Welt ist es eben besser, nicht alles zu hören… Aber wenn nun Maschinen hören lernen? Geht es beim Hören mit KI vielleicht nur darum, dass Maschinen lernen, unser Defizit an akustischer Wahrnehmung auszugleichen?

„Jein“, meint Dagmar Schuller. „Auch alle nicht verbalen Äußerungen – ein Zögern oder Lachen, Weinen, Seufzen, Stöhnen – all das muss erst von Menschen annotiert werden, bevor wir es einer Maschine beibringen können. Die lernt dann: Das ist das und das und das. Allerdings hören die Menschen, die für uns annotieren, all diese Details auch genau auf den Punkt. Sie nehmen alles so genau wahr, wie man es im normalen Leben vielleicht nicht tun würde. Die Maschine hat dann die Möglichkeit, genau dieses Defizit auszugleichen. Dafür muss man ihr aber erst einmal sagen, was das und das ist, damit sie es überhaupt erkennen kann. Hat sie es gelernt, kann sie es besser wahrnehmen als jemand, der nicht genau hinhört. Sie ist dann darauf trainiert z. B. nichtsprachliche Teile der Sprache als gleichwertig wahrzunehmen.“

Die KI soll am Ende nicht nur bestimmte Aspekte des Sprechens wie den Tonfall oder den Rhythmus registrieren. Sie soll vielmehr die Audiosignale und den gesamten Menschen erfassen. Das System von audEERING ist schon jetzt auf das Erkennen von 6.000 Charakteristika trainiert. – „Ein Zögern, eine bestimmte Betonung, Aussprachevarianten, Dialekte… – Es wird nicht nur der Ton gehört, sondern auch die Schwankung, der Verlauf eines Signals oder Atemgeräusche, die zum Beispiel fast komplett nicht tonal sind. Dieses ‚Ha‘ bei einem Erschrecken. Da hört man ja kaum etwas. Aber das System erkennt, wie aufgeregt jemand ist oder wie dominant er spricht. Wir können Persönlichkeitsmerkmale aus der Sprache bzw. aus der Stimme herausfiltern; wie extrovertiert jemand ist, wie empathisch er reagiert… Es sind Dinge, die man sehr vielfältig einsetzen kann.“

Hören mit KI – über kulturelle Grenzen hinweg?

Bevor es um diese Einsatzmöglichkeiten geht… – Werden beim Hören mit KI eigentlich auch kulturelle Besonderheiten berücksichtigt? – Ja, meint Dagmar Schuller, räumt aber ein, dass diese Unterschiede gar nicht so groß sind: „Der Grundstock der Emotionserkennung funktioniert unabhängig von einer bestimmten Sprache. Die Basis-Emotionen lassen sich ohne eine bestimmte Sprache oder Kultur herleiten. Natürlich ist es immer besser, wenn Sie bestimmte Sprach-Corpora berücksichtigen – etwa für Italienisch, Russisch, Chinesisch. Wir haben so etwas bereits vor Jahren entwickelt und z. B. in der Marktforschung mit der GfK getestet. Man kann die Erkennung verbessern, wenn man den Bezug zu einem bestimmten Sprachkorpus hat. Aber diese Corpora sitzen auf unseren Ur-Emotionen. In diesen Ur-Emotionen sind wir Menschen überall gleich.“

In der Steinzeit hatten die Menschen noch keine Sprache: „Das Gegenüber grunzte Sie an. Und in der Art und Weise, wie es grunzte, erkannten Sie, ob Sie laufen müssen oder bleiben können. Das ist wie bei einem knurrenden Hund. Man merkt, ob er spielen will oder gleich zubeißen wird. Der Bezug zum Kulturkreis verbessert das nur noch mal. Chinesische Konnotatoren werden eher merken, ob ein chinesischer Sprecher mehr oder weniger verärgert ist. Andere erkennen das grundsätzlich auch, können aber nicht so genau abstufen. Bei streitenden Italienern ebenso. Wir erleben sie als hoch dramatisch. Ein Italiener würde sagen: Alles normal; das ist in fünf Minuten erledigt. Es ist der feine Unterschied – und nichts anderes als eine zusätzliche Modellvariante, die das System trainieren kann.“

Schauspieler und Hörtraining für Maschinen

Sind Schauspieler*innen eigentlich besonders gut geeignet, um Maschinen das Hören beizubringen? – Nein, meint Dagmar Schuller. Auch wenn andere Anbieter von Hören mit KI ihre Systeme tatsächlich oft von Schauspielern trainieren lassen: „Wenn die dann vor dem System Ärger spielen, dann ist die Leistung beim Erkennen oft extrem hoch – häufig sogar besser als bei unserem System. Das liegt aber daran, dass diese anderen Systeme nicht auf normale Menschen trainiert sind, die ihre Emotionen ganz normal äußern. Wenn hingegen unserem System eine Emotion vorgespielt wird, heißt das noch lange nicht, dass es diese Emotion auch als solche erkennt. Es ist eben auf Otto Normalverbraucher konditioniert und nicht auf Meryl Streep, die eine Emotion als Schauspielerin ganz anders darstellt. Das sind wesentliche Unterschiede. Wenn jemand verärgert ist, ist er nicht nur verärgert. Vielleicht ist er zugleich frustriert oder traurig. Emotionen haben unterschiedliche Ausprägungen. Sie können miteinander vermischt sein. Und die Maschine muss nun entscheiden, ab welchem Grad sie wie erkennt.“

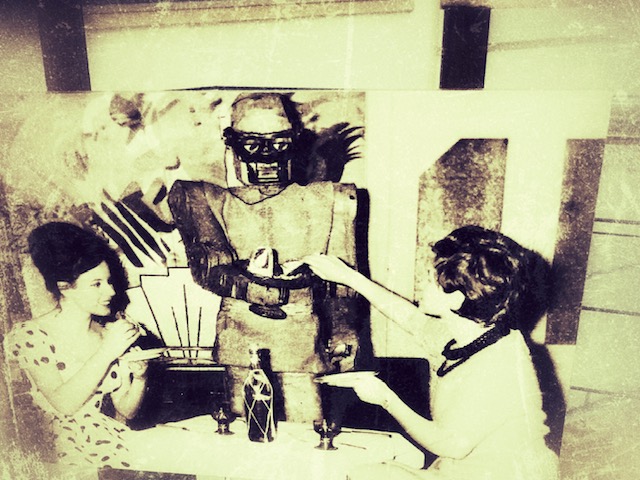

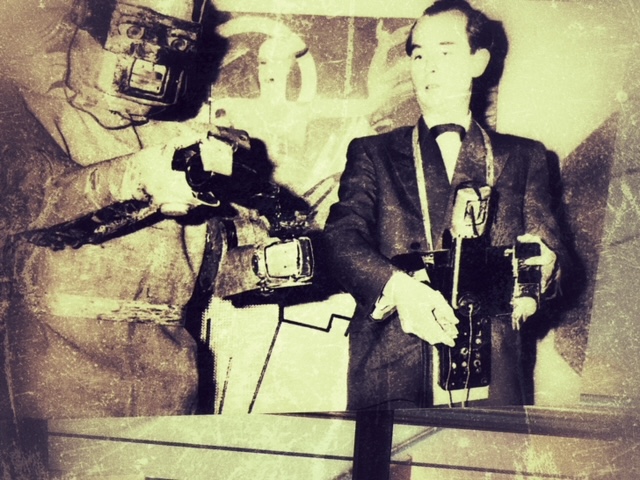

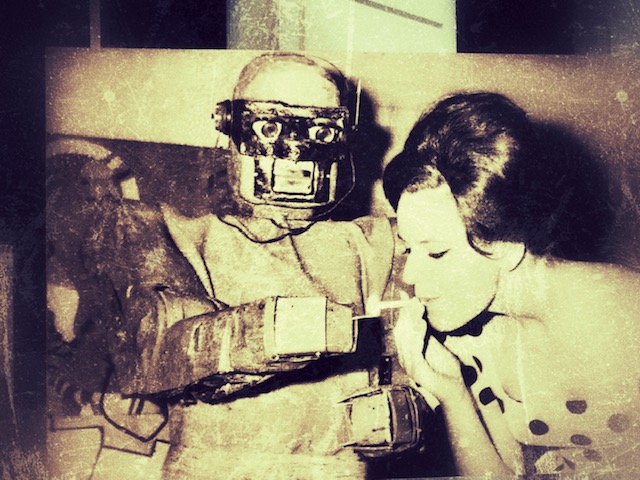

PS 1: Die Abbildungen zum zweiten Teil unserer Artikel-Serie über das Hören mit KI zeigen MM6, den „Maschinenmenschen“ Numero 6 aus dem Jahr 1958, sowie auf den alten Abbildungen die Nachfolgermodelle MM7 und MM8. Entwickelt wurden die MMs alle vom Wiener Kybernetiker Claus Scholz-Nauendorff. MM7 und MM8 sollten zum Beispiel Kaffee eingießen und Leuten aus dem Mantel helfen können. MM6 konnte seine Arme in sechs Stufen bewegen, und er staubte nach dem Tod seines Entwicklers Jahrzehnte lang vergessen vor sich hin, bis er wiederentdeckt wurde. Heute steht er im Technischen Museum Wien.

PS 2: In diesem Blog werden keine aktuellen Produkte bestimmter Unternehmen vorgestellt; der Blog erhält keinerlei Geld oder andere geldwerte Unterstützung. Dass hier mit audEERING ein Unternehmen erwähnt wird, geschieht nur ausnahmsweise und nur, weil es um grundsätzlich neue Entwicklungen geht – und nicht um Werbung.